Vous êtes-vous déjà demandé sur quels critères Facebook se basait pour vous proposer une offre d’emploi?

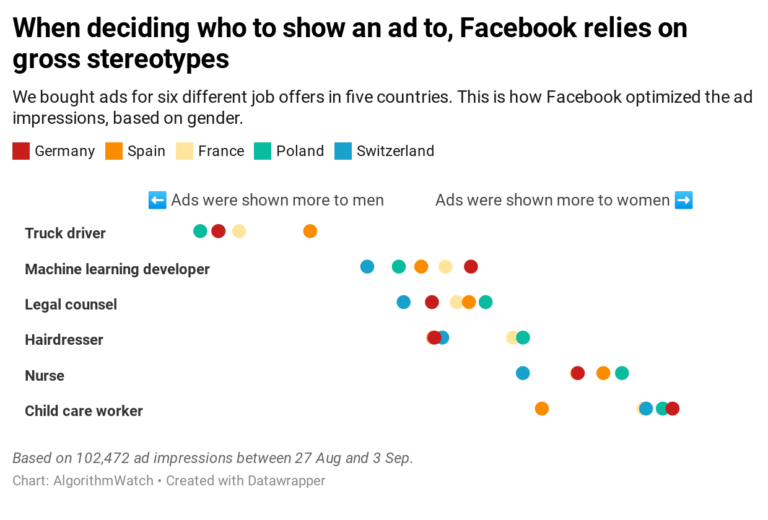

C’est la question que s’est posée l’organisation AgorithmWatch. En collaboration avec la RTS, elle a mené une expérience sur les algorithmes de Facebook et de Google. Six encarts publicitaires dans cinq pays différents (Suisse, Allemagne, Pologne, France, Espagne) ont été achetés sur Facebook et Google pour des offres d’emploi de : développeur de machines d’apprentissage, camionneur, coiffeur, éducateur de jeunes enfants, conseiller juridique et infirmier. Les résultats ont montré que les algorithmes de Facebook et Google (dans un moindre mesure) ciblaient leurs offres d’emploi en fonction du sexe des utilisateurs. L’annonce de chauffeur poids-lourds, a par exemple été diffusée en Suisse à 3607 hommes, contre 631 femmes. Celle d’éducateur de jeunes enfants a été montrée à 1203 femmes pour 369 hommes.

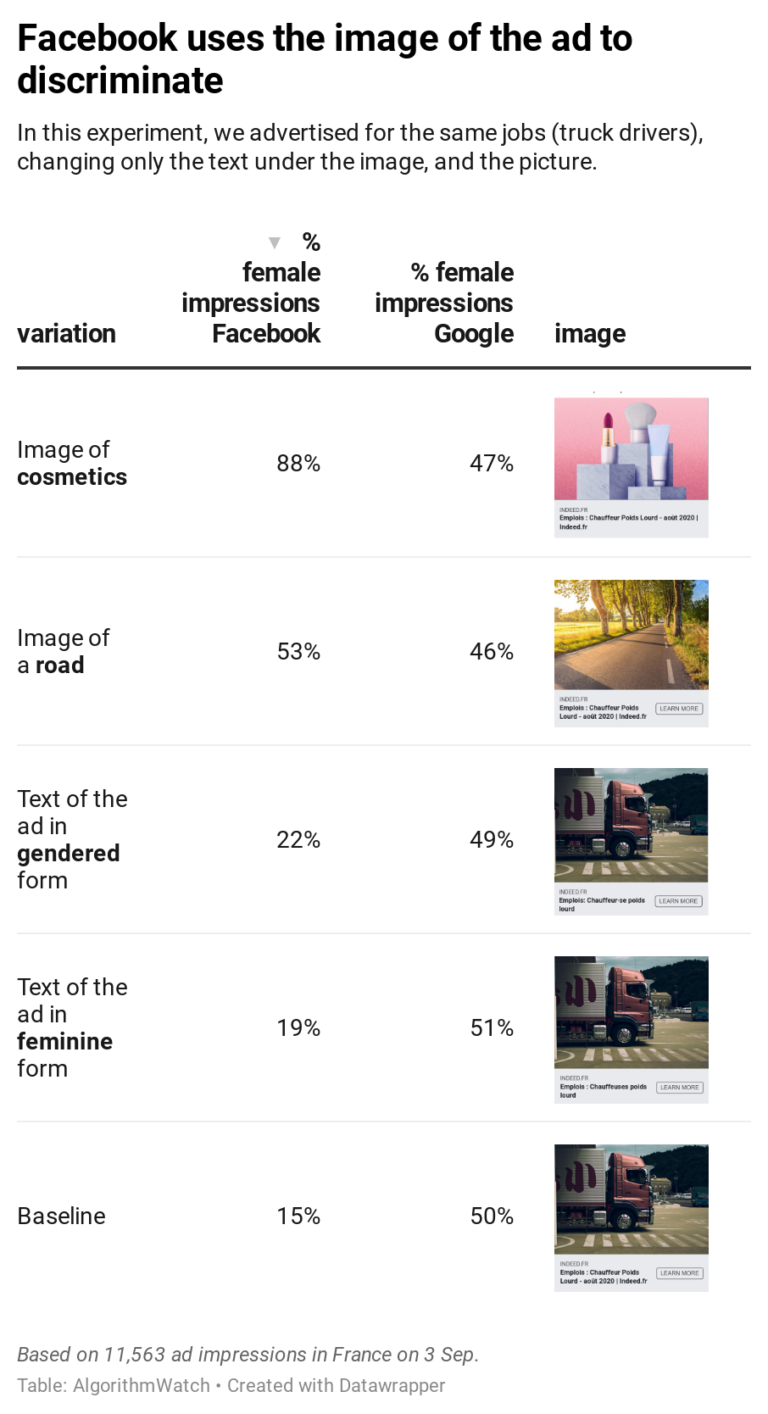

L’équipe d’AlgorithmWatch a également relevé que l’algorithme de Facebook se basait principalement sur l’image utilisée dans l’annonce pour décider sur quels fils d’actualité la faire apparaitre. (Tran-Tien, Zufferey, 2020).

Cette expérience fait écho à l’étude “Discrimination through optimization: How Facebook’s ad delivery can lead to skewed outcomes” réalisée en 2019 par des chercheurs de la Northeastern University Massachusetts, qui a relevé des biais significatifs liés au sexe et à la race pour des annonces d’offres d’emploi et de logements diffusées sur Facebook (Ali et al., 2019).

Pensez-vous que vos rencontres sur Tinder sont le fruit du hasard?

Dans son ouvrage “Amour sous algorithme” paru en 2019, Judith Duportail a réalisé un enquête journalistique sur l’algorithme de Tinder. Elle a rencontré Jessica Pidoux, doctorante en humanités digitales à l’EPFL qui rédige une thèse sur “Les métriques de la rencontre en ligne“. Durant ses recherches, la doctorante a déniché un brevet qui explique le fonctionnement de l’algorithme. En se basant sur les données partagées par les utilisateurs, ce dernier détermine un “score personnel de désirabilité” en fonction de l’intelligence supposée, de l’éducation, du style d’écriture, de l’attractivité physique, du niveau de revenu, du succès et du temps passé sur l’application (Robert, 2020). Les gens sont ensuite mis en relation en fonction de cette note. Selon Jessica Pidoux, l’algorithme se base sur un modèle patriarcal ou “les hommes aisés sont plus susceptibles de tomber sur des profils de femmes moins éduquées”(Delafoi, 2020) ce qui créé du sexisme et de la discrimination.

Connaissez-vous l’algorithme Perspective qui détecte automatiquement les discours haineux sur internet ?

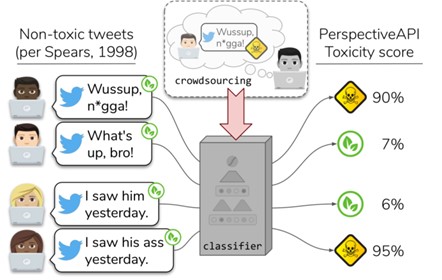

Malheureusement ce dernier aurait un biais raciste envers la communauté afro-américaine. Des chercheurs de l’Université de Washington ont découvert que Perspective avait été entrainé avec des données contenant des préjugés raciaux. En effet, la base de données utilisée contenait plus de 100’000 tweets annotés par des humains afin de détecter les propos haineux. Les tweets qui utilisaient l’argot afro-américain avaient été classés plus fréquemment comme étant du contenu “toxique”. Ce biais sur les données d’entrainement de Perspective a eu pour conséquence que les tweets publiés par des personnes afro-américaines avaient ainsi 1.5 à 2 fois plus de chance d’être catégorisés comme étant “offensants”. Il a rendu l’algorithme raciste envers la population noire et a contribué à la censure de cette communauté (Laurent, 2019).

J’aurais encore pu vous parler des erreurs liées au système de reconnaissance facile. La dernière victime en date, Robert Julian-Borchak Williams, a été arrêté à Détroit pour un crime qu’il n’avait pas commis, suite à l’utilisation d’un système de reconnaissance faciale défectueux. Ou encore, de l’algorithme de Twitter qui favorise les images ayant davantage de contraste. Cela provoque un biais raciste en privilégiant les images de visages blancs au détriment de visages noirs.

Tous ces exemples nous montrent que les algorithmes sont loin d’être objectifs et neutres. On trouve un grand nombre de biais algorithmiques (race, genre, sexe…) qui peuvent avoir un impact sur tous les domaines de notre vie, notre vie professionnelle, nos loisirs, notre sécurité, jusque dans nos rencontres amoureuses. Je vous conseille d’ailleurs la lecture de cet article sur le Big data et la police prédictive.

Quelques pistes en conclusion

- En premier lieu, une plus grande diversité des concepteurs, qui sont encore trop blancs et masculins, permettrait de détecter plus aisément les erreurs.

- Il s’agit ensuite de s’assurer de la qualité, de la quantité et de la pertinence dans la collecte et le traitement des données d’apprentissage (Demiaux, Si Abdallah, 2017).

- L’équité des algorithmes est un domaine de recherche du machine learning qui se développe et qui pourra amener des solutions (Bertail et al., 2019, p. 14)

- Plusieurs voix se font entendre pour demander une régulation des algorithmes. 42 pays dont la Suisse, ont d’ailleurs adopté en 2019, les nouveaux principes de l’OCDE sur l’AI.

Comme l’a dit la chercheuse numérique Aurélie Jean (cité par Hanitrarivo, 2020), “L’algorithme n’est pas coupable, ni sexiste, ni raciste… Ce sont nous, les humains, qui sommes machos, racistes, sexistes, et qui devons prendre nos responsabilités par rapport à ces algorithmes“.

Bibliographie

ALI, Muhammad, SAPIEZYNSKI, Piotr, BOGEN, Miranda, KOROLOVA, Aleksandra, MISLOVE, Alan et RIEKE, Aaron, 2019. Discrimination through optimization: How Facebook’s ad delivery can lead to skewed outcomes. In : Proceedings of the ACM on Human-Computer Interaction. 7 novembre 2019. Vol. 3, n° CSCW, p. 1‑30. DOI 10.1145/3359301.

BERTAIL, Patrice, BOUNIE, David, CLÉMENÇON, Stephan et WAELBROECK, Patrick, 2019. Algorithmes : biais, discrimination et équité. In : HAL archives ouvertes [en ligne]. 2019. Disponible à l’adresse : https://hal.telecom-paris.fr/hal-02077745/document.

DELAFOI, Florian, 2020. Jessica Pidoux, l’algorithme de Tinder dans la peau. In : Le Temps [en ligne]. 24 février 2020. [Consulté le 21 novembre 2020]. Disponible à l’adresse : https://www.letemps.ch/societe/jessica-pidoux-lalgorithme-tinder-peau.

DEMIAUX, Victor et SI ABDALLAH, Yacine, 2017. Comment permettre à l’homme de garder la main? : les enjeux éthiques des algorithmes et de l’intelligence artificielle : synthèse du débat public animé par la CNIL dans le cadre de la mission de réflexion éthique confiée par la loi pour une république numérique. In : CNIL [en ligne]. décembre 2017. Disponible à l’adresse : https://www.cnil.fr/sites/default/files/atoms/files/cnil_rapport_garder_la_main_web.pdf.

HANITRARIVO, Micka, 2020. Pourquoi certains algorithmes sont-ils racistes et sexistes ? In : Daily Geek Show [en ligne]. 20 mars 2020. [Consulté le 21 novembre 2020]. Disponible à l’adresse : https://dailygeekshow.com/algorithmes-racistes-sexistes/.

LAURENT, David, 2019. Le détecteur de langage haineux de Google est raciste. In : Presse-citron [en ligne]. 14 août 2019. [Consulté le 21 novembre 2020]. Disponible à l’adresse : https://www.presse-citron.net/le-detecteur-de-langage-haineux-de-google-est-raciste/.

ROBERT, Arnaud, 2020. Tinder : dans le ventre de lʹappli. In : Vacarme [en ligne]. 3 juin 2020. [Consulté le 21 novembre 2020]. Disponible à l’adresse : https://www.rts.ch/play/radio/vacarme/audio/tinder-35-dans-le-ventre-de-lappli?id=11336332. Play RTS

SAP, Maarten, CARD, Dallas, GABRIEL, Saadia, CHOI, Yejin et SMITH, Noah A., 2019. The Risk of Racial Bias in Hate Speech Detection. In : Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics [en ligne]. Florence, Italy : Association for Computational Linguistics. juillet 2019. p. 1668–1678. [Consulté le 21 novembre 2020]. Disponible à l’adresse : https://www.aclweb.org/anthology/P19-1163.

TRAN-TIEN, Cécile et ZUFFEREY, Dimitri, 2020. L’algorithme de Facebook est sexiste pour les offres d’emploi. In : rts.ch [en ligne]. 18 octobre 2020. [Consulté le 21 novembre 2020]. Disponible à l’adresse : https://www.rts.ch/info/sciences-tech/technologies/11684864-lalgorithme-de-facebook-est-sexiste-pour-les-offres-demploi.html.

Laisser un commentaire