Et tu commences…

Il était une fois – derechef – dans une cité mythique du monde arabo-musulman, un jeune homme pauvre qui avait aperçu la fille du roi et en était tombé amoureux…

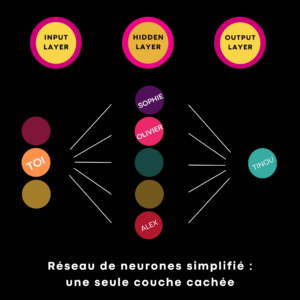

Et la voix du savoir de marteler, sans répit : « Le deep learning, consiste à apprendre à un réseau de neurones artificiels à faire des prédictions. Le réseau, multicouche, comporte les neurones d’entrée avec les données d’apprentissage (input), les couches cachées (l’espace latent où les neurones décomposent les informations en caractéristiques) et la sortie (output). »

Toujours aussi soporifique ? Viens. Nous allons enseigner les contes des 1001 Nuits à la Machine. En input, tu insères Aladdin (forward pass). Olivier, Sophie et Alexandra (couche cachée) le décomposent et identifient progressivement ses caractéristiques. Ils transmettent l’histoire à Tinou (sortie).

Si celle-ci s’exclame « C’est le conte d’Ali Baba ! », c’est que le bush telegraph, ou téléphone arabe, a distordu son output. Il te faut mesurer son erreur et faire demi-tour. Remonte les couches pour ajuster le poids des informations transmises par chacun des trois copains précités.

Vanishing Gradients

Dans un réseau très profond (avec beaucoup de couches), certaines informations se perdent en remontant. Lorsqu’elles arrivent à la sortie, il n’y a presque plus rien à corriger. Le réseau « oublie » les premières étapes.

- Tu contes le récit d’Aladdin à l’oreille de Sophie : Il y avait une fois, dans une cité du monde arabo-musulman du XIIe siècle, un jeune homme pauvre qui avait aperçu la fille du roi et en était tombé amoureux.

- Sophie le transmet à Olivier et à Alexandra : “Il y avait une fois dans une cité du monde [

arabe…], un jeune homme pauvre qui avait aperçu la fille du roi et en était tombé amoureux. - Olivier à Tinou : « Il y avait une fois [

…] un jeune homme pauvre qui avait aperçu une fille [de roi] et en était tombé amoureux. - Alexandra à Tinou : « Il y avait une fois [

…] un jeune homme [pauvre]qui avait aperçu une fille […] et en était tombé amoureux.

Sophie a omis le contexte historique, Olivier, le statut de la jeune fille et Alexandra, le milieu social d’Aladdin. Tinou a produit une approximation statistique des versions d’Aladdin où celui-ci pourrait bien se retrouver en costume de tweed dans les fifties avec une belle en robe de gala.

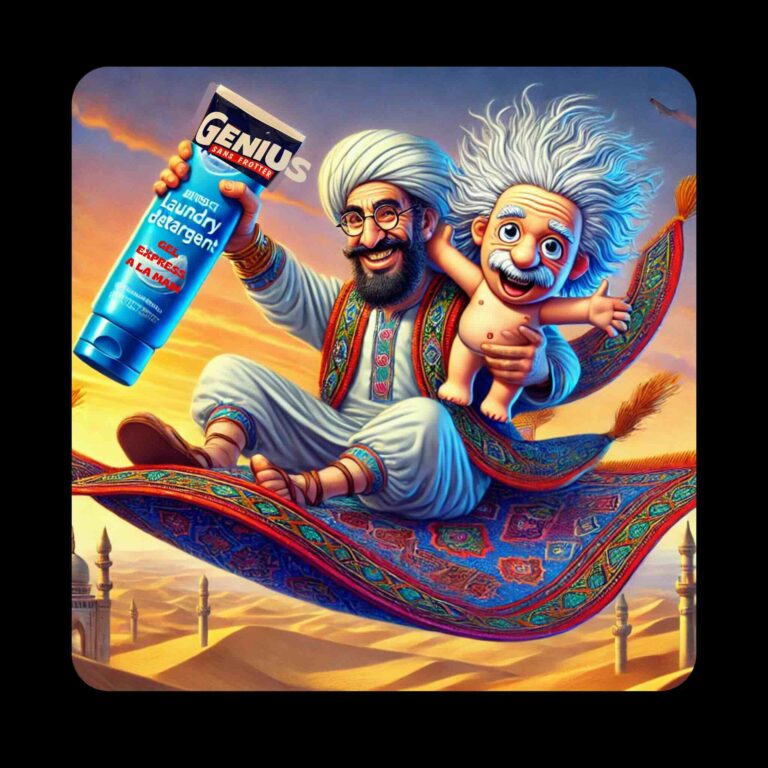

Exploding Gradients

C’est l’inverse : les informations prennent plus en plus de poids en remontant les couches.

- Tu contes à l’oreille de Sophie : Aladdin, qui avait du génie, eut l’idée de frotter la lampe. Un djinn (un génie) en sortit, lui proposant d’exaucer trois de ses vœux.

- Sophie transmet à Olivier et Alexandra : “ Aladdin, qui avait du génie, eut l’idée de frotter la lampe et un djinn imposant en sortit, lui proposant d’exaucer…

- Olivier à Tinou : « Aladdin, qui avait emporté du Génie, eut l’idée de frotter la lampe et un très grand génie en sortit, qui lui proposa d’exaucer…

- Alexandra à Tinou : Aladdin, qui avait emporté du Génie, eut l’idée de frotter la lampe et l’un des plus grands génies de l’histoire en sortit, lui proposant d’exaucer…

Sophie a donné du poids au djinn (génie en arabe). Olivier, soucieux qu’il est de ses lainages, a introduit un biais de contexte en confondant le génie avec une lessive. Alexandra, toujours admiratrice des grands humanistes, a un peu trop insisté sur l’ampleur du génie. Le génie pèse trop lourd dans ce réseau.

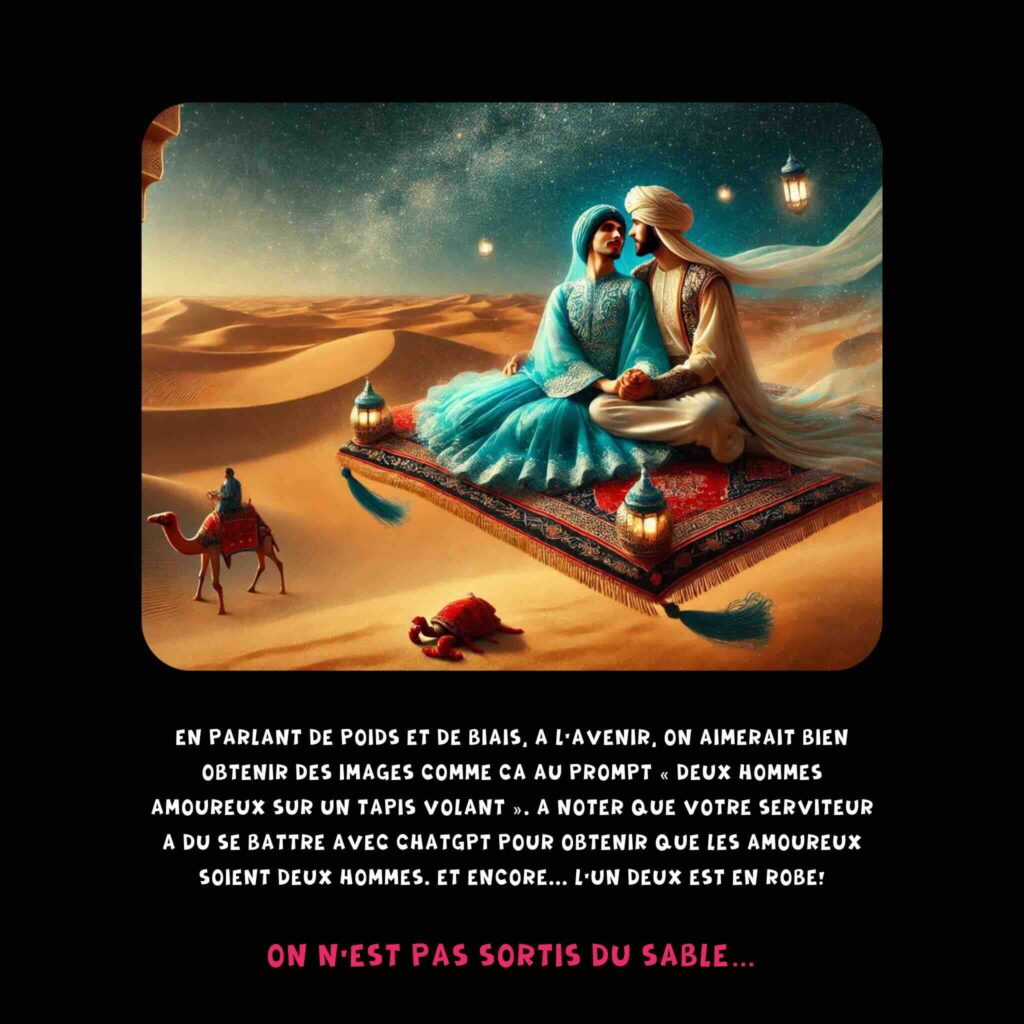

Une histoire d'amour...

NdA : les stratégies d’apprentissage oniriques présentées ici n’engagent que leur auteur. Il est recommandé de réviser régulièrement et d’écouter attentivement en classe.

Bibliographie

IBM. Qu’est-ce qu’un réseau neuronal récurrent (RNN) ?. IBM topics. https://www.ibm.com/fr-fr/topics/recurrent-neural-networks [consulté le 4 décembre 2024].

DEEP AI, Inc. Exploding Gradient Problem. DeepAI.org (glossaire). https://deepai.org/machine-learning-glossary-and-terms/exploding-gradient-problem [consulté le 4 décembre 2024].

DEEPLIZARD, 2018. Vanishing & Exploding Gradient explained | A problem resulting from backpropagation. 23 mars 2018. Disponible à l’adresse : https://www.youtube.com/watch?v=qO_NLVjD6zE [consulté le 4 décembre 2024].

Pour aller plus loin: ZUCCHET, Nicolas & ORVIETO, Antonio, 2024. Recurrent neural networks: vanishing and exploding gradients are not the end of the story. arXiv [en ligne]. 5 novembre 2024. 40 pages. DOI : https://doi.org/10.48550/arXiv.2405.21064

Laisser un commentaire